IT w firmach: sześć głównych trendów

Analitycy zwracają uwagę, że co siedem lat mamy do czynienia z rynkowymi perturbacjami. A jeśli tak, to obecny rok może nam przynieść nieprzyjemny przełom.

Teoria siódemek może

wydawać się spiskowa, ale… coś w tym jest. Siedem lat temu zaczęło się

trwające do dziś spowolnienie gospodarcze spowodowane załamaniem rynku kredytów

w USA. Wydarzeń 11 września 2001 r. i ich konsekwencji nie trzeba

nikomu przypominać. W 1994 r. załamał się rynek obligacji w USA, zaś

19 października 1987 r. zyskał miano Czarnego Poniedziałku – wtedy to

większość indeksów giełdowych na świecie spadła o kilkadziesiąt procent.

Czy jako ekonomicznie negatywne wydarzenie roku już teraz

można potraktować uwolnienie przez Narodowy Bank Szwajcarii kursu franka wobec

euro w połowie stycznia? Nagły wzrost kursów wszystkich głównych walut nie

ułatwia życia importerom, ale rosnący o 20 proc. w ciągu jednego

dnia frank znacznie obniżył też siłę nabywczą kilkuset tysięcy rodzin

spłacających kredyty hipoteczne w tej walucie, co z pewnością nie

poprawi nastrojów w gospodarce.

Pozostaje mieć nadzieję,

że jednak w 2015 r. nie będziemy mieli do czynienia z kolejnymi

rynkowymi zawirowaniami, wywołanymi np. aktywnością terrorystyczną o dużym

zasięgu. Tego rodzaju trudności szczególnie mocno uderzyłyby w rynek

systemów IT dla przedsiębiorstw. Firmy w trudnych czasach jako pierwsze

ograniczają wydatki na rozwój. Na razie jednak w tym segmencie rynku

panuje stabilizacja, która dotyczy również samych technologii. Poprzedni rok

nie przyniósł żadnych rewolucyjnych zmian, zarówno pod kątem rozwiązań IT dla

firm, jak też centrów przetwarzania danych.

Brak rewolucyjnych

przełomów nie oznacza jednak, że nic się nie dzieje. Co więcej, po raz pierwszy

w historii zaczynamy mieć do czynienia z sytuacją, w której to

działania konsumentów będą miały znaczący wpływ na to, jak funkcjonuje IT

w firmach. Wynika to m.in. z umacniającego się trendu BYOD oraz

rosnącej popularności usług w chmurze. Do ich świadczenia potrzebny jest

bowiem sprzęt klasy korporacyjnej.

• BYOD

wciąż kontrowersyjny

W USA, skąd do Europy przywędrował trend BYOD, stał się on

codziennym wyzwaniem dla szefów i administratorów IT. Według różnych

szacunków już ponad 50 proc. firm zza oceanu umożliwia dostęp do swoich

danych z prywatnych urządzeń. To wyjątkowo korzystnie wpłynęło na sprzedaż

systemów klasy Mobile Device Management (MDM), które ułatwiają zarządzanie

urządzeniami mobilnymi i zgromadzonymi na nich treściami. Rośnie też

zainteresowanie systemami wirtualizacji aplikacji i desktopów, dzięki

którym urządzenie pracownika działa jak monitor komputera – nie są na nie

przesyłane żadne dane, a więc nie będzie mogło dojść do ich wycieku.

Pierwsze doświadczenia amerykańskich administratorów

z BYOD nie są jednak najlepsze. Liczba spraw serwisowych kierowanych do

działów wsparcia nie spadła tak drastycznie, jak pierwotnie przewidywano.

Użytkownicy korzystają z wielu różnorodnych środowisk, a na dodatek

systemy operacyjne urządzeń są dość często aktualizowane. To powoduje, że nie

zawsze służbowe aplikacje instalowane na prywatnych telefonach czy tabletach

działają poprawnie. Główną zauważalną korzyścią jest spadek liczby kradzieży

lub zagubień takich urządzeń, co bezpośrednio wpływa na zmniejszenie ryzyka

wycieku danych. Pracownicy znacznie bardziej dbają o swój prywatny sprzęt,

co też przekłada się na jego mniejszą awaryjność.

BYOD stał się popularny w USA pod koniec ubiegłej

dekady, gdy użytkownicy zapragnęli wykorzystać do służbowych celów swoje

prywatne iPhone’y, które przez pierwsze lata obecności na rynku w ogóle

nie były traktowane jako rozwiązanie korporacyjne. Ale w Europie, gdzie

decyzja o kupnie urządzenia z logo nadgryzionego jabłka nie jest tak

oczywista jak za oceanem, zatrudnione przez firmy osoby wykazują znacznie

większą obojętność wobec sprzętu, który dostarczy im pracodawca. Nie widzą

zatem uzasadnienia dla płacenia z własnej kieszeni za urządzenie

wykorzystywane do pracy. Co więcej, czasami budzi to ich wyraźny sprzeciw,

i jest to trend zauważalny także w Polsce.

• Choose

Your Own Device

IDC przeprowadziło w Europie badania, z których

wynika, że w co drugiej firmie nie rozważa się przyjęcia formalnej

strategii działań BYOD. Natomiast ma ją już obecnie – w zależności od

kraju – jedno na trzy lub cztery przedsiębiorstwa. Proporcje te mają

pozostać na podobnym poziomie przez kilka najbliższych lat.

W coraz większej liczbie firm realizuje się też

politykę, która jest swego rodzaju kompromisem między dotychczasowym modelem

(przedsiębiorstwo udostępnia pracownikowi narzędzia dostępu do danych)

a BYOD. Określono ją jako Choose Your Own Device (CYOD), czyli możliwość

wyboru przez pracownika preferowanego przez niego urządzenia ze stworzonej

przez pracodawcę listy dostępnych modeli. Różnią się one marką, systemem

operacyjnym, wielkością ekranu itd. Dzięki temu pracownik może korzystać ze

środowiska, które zna i lubi, a jednocześnie nie musi za nie płacić.

W takim przypadku administratorzy mają pełne prawo do zarządzania

urządzeniami i kontroli ich zawartości.

Taka zmiana trendu to dobra wiadomość dla resellerów.

Zaakceptowanie przez ich klientów modelu BYOD oznaczało bowiem likwidację

dużych kontraktów na dostawy sprzętu IT i urządzeń mobilnych. Użytkownicy

prywatni często kupowali te urządzenia w sklepach wielkopowierzchniowych

lub u operatorów, pomijając klasyczny kanał resellerski. Teraz ten

niepokojący dla resellerów trend może zacząć słabnąć.

• Jak

podejść do wielkich zbiorów danych?

Drugim,

obok BYOD, pojęciem, które w ostatnich latach zyskało fenomenalną

popularność, jest Big Data. W Polsce

prawdziwe projekty tego typu mogą być realizowane praktycznie przez mniej niż

sto firm – banki, firmy ubezpieczeniowe, operatorów telekomunikacyjnych,

pojedyncze sieci handlowe czy instytucje dostarczające różnego typu media, jak

woda, gaz czy energia elektryczna. W krajach, w których gospodarka

opiera się na przedsiębiorstwach sieciowych lub franczyzach (a nie, jak

w Polsce, na bardzo drobnej rozproszonej przedsiębiorczości), liczba

podmiotów zainteresowanych analityką w modelu Big Data jest liczona

w dziesiątkach tysięcy.

Niestety, podobnie jak w przypadku chmury kilka lat

temu, znaczenie tego pojęcia zostało wypaczone przez działy marketingu firm,

które na siłę próbowały „podłączyć” do Big Data systemy niemające z tą

koncepcją wiele wspólnego. Najlepszym przykładem jest tu branża pamięci

masowych, która wskazuje, że skoro danych jest bardzo dużo, to potrzebna będzie

ogromna przestrzeń do ich przechowywania. Jest to błędne założenie, bowiem

słowo „big” opisuje tu bardziej ilość informacji, a nie objętość danych.

W praktyce okazuje się, że przeznaczone do analizy dane rzadko zajmują

przestrzeń rzędu terabajtów. Zdecydowanie częściej są to bardzo małe porcje

informacji, np. pochodzące z systemów inteligentnych liczników czy

dzienników systemów transakcyjnych.

Nie

oznacza to jednak, że w takich krajach jak Polska trudno będzie

o projekty z zakresu Big Data. Właściwie każde przedsiębiorstwo

dysponuje danymi, z których – przy umiejętnej analizie – można

wyciągnąć ciekawe i wartościowe wnioski. Na rynku dostępnych jest wiele

narzędzi do prowadzenia analizy biznesowej nawet w małych

przedsiębiorstwach i to w ich wdrażaniu resellerzy powinni upatrywać

swojej szansy. Szczególne korzyści mogą też osiągnąć ci, którzy równolegle będą

w stanie świadczyć usługi doradcze związane z analizą danych.

• Internet

(wszystkich?) rzeczy

O urządzeniach gospodarstwa domowego podłączanych do

Internetu mówi się już od lat 90. Jednak wizja lodówki samodzielnie

zamawiającej mleko nie wszystkim przypadła do gustu. W czasach

permanentnej inwigilacji nie dziwi sceptycyzm, szczególnie wśród narodów

przedkładających prywatność nad wygodę. Klienci wskazują natomiast na jedną

funkcję, którą chcieliby widzieć w urządzeniach (także AGD) podłączonych

do Internetu. Chodzi o możliwość automatycznego raportowania stanu

technicznego sprzętu w celu wczesnego wykrycia ewentualnych usterek.

Najlepiej zanim woda z pralki zaleje łazienkę czy rozmrozi się zamrażalnik

podczas urlopu. Ale tutaj prawdopodobnie napotkamy na opór samych producentów.

W ich interesie nie leży przesadna dbałość o jak najdłuższą,

bezawaryjną pracę sprzedawanych urządzeń. Po okresie gwarancji klient powinien

poczuć potrzebę kupna nowego modelu.

Inaczej sprawy się mają w przypadku systemów

pomiarowych stosowanych przez instytucje użyteczności publicznej. Automatycznie

raportujące stan pracy liczniki prądu, gazu czy wody zapewniają możliwość

sprawowania stałej kontroli nad infrastrukturą, zapobiegania dużym awariom czy

nadużyciom ze strony klientów.

Podsumowując, Internet rzeczy to ciekawy pomysł, ale trudno

spodziewać się rewolucji w tym zakresie. Oczywiście rozszerzana będzie

lista rodzajów urządzeń, które można podłączyć do Internetu, ale w tym

przypadku raczej nie sprawdzi się dewiza Steve’a Jobsa, który twierdził, że

ludzie potrzebują określonych rozwiązań, tylko nie zdają sobie z tego

sprawy…

• Zalew danych z

ubieralnych urządzeń

Jedna z teorii krążących po rynku IT głosi, że już wkrótce

producenci dysków twardych i pamięci flash mają nie nadążyć z produkcją.

Chodzi o ogromne zapotrzebowanie na przestrzeń spowodowane lawinowo rosnącą

liczbą prywatnych zdjęć i filmów. Ma to być też wyzwanie dla dostawców

przestrzeni w chmurze publicznej, gdzie trafia wiele z tych treści.

Do tego będzie dochodzić lawina danych z „ubieralnych” urządzeń. Wszystko

wskazuje jednak, że na sprawdzenie się tej prognozy przyjdzie nam zaczekać. Po

publicznej prezentacji elektronicznych okularów Google Glass przez kilka

miesięcy mieliśmy do czynienia z ogromnym zainteresowaniem tym gadżetem,

które jednak finalnie przekształciło się w… społeczny bunt związany

z prawem do zachowania wizerunku i poufności, a wręcz – intymności.

Mimo że dziś o cyfrowych okularach mówi się mniej, Google nie zaniechał

tego projektu – obecnie szuka partnerów, którzy są w stanie

przygotować na nie ciekawe aplikacje i jednocześnie przyczynią się do

komercyjnego sukcesu.

Szybko

minął też entuzjazm po pierwszych premierach inteligentnych zegarków. Ludzie

zaczynają mieć dość kolejnych urządzeń, które muszą ładować, pamiętać

o ich zabraniu z domu, chronić przed zgubieniem czy wyciekiem

znajdujących się na nich danych. Z tego też powodu wyhamowała sprzedaż

tabletów, a często wręcz stała się nieopłacalna – dostępność wielu

tanich modeli o wątpliwej jakości zdeprecjonowała funkcjonalność

urządzenia. Przy okazji zniechęciła wielu użytkowników do kupna lepszego,

bardziej funkcjonalnego i wytrzymałego sprzętu.

• Chmura lekarstwem

na wszystko?

O zbawiennych właściwościach chmury użytkownicy są

przekonywani od co najmniej dekady. Usługi świadczone przez Internet mają być

łatwiej dostępne, tańsze i bezpieczniejsze niż rozwiązania instalowane

w firmie lub na urządzeniach użytkownika. W wielu przypadkach

rzeczywiście tak jest, ale wciąż daleko do sytuacji, gdy będzie można mówić

o powszechnym biznesowym zastosowaniu chmury publicznej. Nie pomaga

odwoływanie się do faktu, że mało która firma ma dzisiaj własne ujęcie wody, bo

korzysta z publicznie dostępnej infrastruktury. Skala problemów

generowanych przez chmurowe rozwiązania IT jest zupełnie inna.

Obecnie, po kilku latach funkcjonowania usług chmury

publicznej na Zachodzie, wielu użytkowników ma już pewne doświadczenia. Okazuje

się, że nie zawsze jest ona bezpieczniejsza (wycieki danych), dostępniejsza

(wolny transfer i wysokie koszty szybkich łączy) czy tańsza (spore ryzyko

przekroczenia założonego budżetu z powodu swobody rozbudowywania pierwotnie

zaplanowanego środowiska) niż tradycyjny model korzystania

z infrastruktury IT.

W wielu firmach usługi chmury publicznej doprowadziły

do powstania niekorzystnego zjawiska zwanego Shadow IT. Polega ono na tym, że

użytkownicy (najczęściej kierownicy projektów), nie mogąc porozumieć się

z działami IT w zakresie potrzebnych zasobów lub aplikacji, sami

decydują o ich zakupie w chmurze publicznej, z całkowitym

pominięciem oficjalnych struktur IT. Wystawiają tym samym na ryzyko firmowe

dane, jak też pozbawiają się niezbędnego wsparcia. Taka wewnętrzna konkurencja

spowodowała, że działy IT zostały zmuszone do współpracy z usługodawcami,

których – w ramach Shadow IT – działy biznesowe same sobie

wybrały.

Kilka lat doświadczenia pokazuje jednak, że chmura to

bardzo ciekawy pomysł dla firm małych i średnich, których w Polsce

jest zdecydowana większość. Nie muszą budować własnych serwerowni, co

– szczególnie na początku działalności – stanowi niemały koszt. Abonamentowy

model rozliczania to główna korzyść, która zapewnia płynność finansową. Jest

jeszcze jedna przyczyna, dla której mniejsze przedsiębiorstwa mogą być

zainteresowane usługami w chmurze: 14 lipca 2015 r. Microsoft zakończy

wsparcie dla systemu Windows Server 2003. Instalacja nowej wersji serwerowego

systemu dla większości użytkowników będzie wiązała się z koniecznością

równoległej inwestycji w serwery. Alternatywą mogą okazać się usługi

w modelu Infrastructure as a Service oraz Platform as a Service.

Maciej Szeptycki

dyrektor

techniczny, Cisco

Użytkownicy coraz bardziej oczekują otwartych, prostych i

intuicyjnych rozwiązań, które znają z używanych na co dzień aplikacji webowych.

Dzięki stosowanemu w warstwie sieciowej modelowi Software Defined Network

możliwe jest zapewnienie także aplikacjom biznesowym odpowiedniej wydajności w

kontekście jakości przesyłania danych.

To na centrach danych skupi się przede wszystkim

działanie większości rozwiązań programowych budowanych przez najbliższe lata. Fundamentalnie

nowe podejście do potrzeb klientów i rozwiązania takie jak architektura Cisco

Application Centric Infrastructure są już weryfikowane przez rynek.

Krzysztof Celmer

Country Manager Poland, Citrix Systems

Nadchodzący rok będzie sprzyjać rozwojowi wirtualizacji

desktopów, w tym popularyzacji usług Dekstop as a Service, które zarówno ze

względu na coraz większe wykorzystanie chmury obliczeniowej oraz mobilności w

biznesie w ciągu ostatnich miesięcy dojrzały pod względem technologicznym. Rozwijał

się będzie też rynek wirtualizacji desktopów jako takich. Hostowane wirtualne

desktopy będą dobrą alternatywą zarówno dla mniejszych podmiotów, nowych

organizacji, jak i nowo otwieranych oddziałów już istniejących firm, które z

racji niższych kosztów oraz lepszej efektywności i bezpieczeństwa skierują się

w stronę rozwiązań opartych na chmurze.

Kolejnym kierunkiem, który będzie rozwijał się w 2015 r.,

jest mobilność, zresztą jej upowszechnienie pozostaje w ścisłej korelacji z wirtualizacją desktopów.

Coraz większa liczba dostawców usług oraz innych firm szuka szybkiego sposobu

na osiąganie korzyści biznesowych z wykorzystaniem kompletnych, mobilnych

środowisk pracy, w ramach których aplikacje, desktopy i dane są bezpiecznie

dostarczane pracownikom za pośrednictwem dowolnego urządzenia czy sieci.

Tomasz Wieczorek

CEE Enterprise Product Manager, Dell

Widzimy ogromny potencjał w rozwiązaniach prostych,

efektywnych i możliwie elastycznych, czyli takich, które pozwolą nowoczesnym

firmom działać szybciej i skuteczniej, ograniczać koszty związane z systemami

IT oraz zawsze być gotowym na zmiany. Rozwiązania IT w 2015 r. będą

konsekwentnie ewoluować w kierunkach, które zostały już określone na

przestrzeni minionych miesięcy. Ważnym zadaniem dla firm i organizacji

pozostanie upraszczanie wykorzystywanych środowisk – wychodzenie z silosowego

IT i coraz śmielsze wdrażanie infrastruktury współdzielonej.

Future Ready IT to kolejny wyraźny trend, który zyskuje

na znaczeniu. Budowa elastycznych centrów danych możliwych do szybkiej

implementacji jest odpowiedzią na dynamiczny rozwój całego sektora IT, bo

dzięki tak określonej strategii firmy będą zawsze o krok przed nadchodzącą

zmianą i będą mogły szybko dostosować się do nowych wymagań rynku.

Radomir Bordon

dyrektor

technicznego wsparcia sprzedaży, EMC

Większość z wyzwań dotyczących przechowywania danych w

2015 r. będzie związanych z lawinowym wzrostem ilości informacji generowanych i

przechowywanych przez firmy. Trend dotyczący składowania i analizy Big Data

oraz obietnice z nim związane powodują, że firmy – zgodnie z ideą „składuj

wszystko, analizuj co chcesz” (store everything, analyze anything) – zaczną

gromadzić absolutnie wszystkie dane, wierząc, iż będzie możliwe wyciągnięcie z

nich wartościowych informacji dla biznesu. Pomocny będzie w tym system plików

HDFS (Hadoop Distributed File System).

Nasilał się będzie też trend nazywany 'Shadow IT”.

Odnosi się on do „skłonności” niektórych działów biznesowych w firmach do

samodzielnego zlecania tworzenia aplikacji niezbędnych do budowania przewagi

konkurencyjnej przy wykorzystaniu zewnętrznych, publicznych dostawców

technologii (jak AWS), w szczególności obiektowego składowania i adresowania

danych.

Wojciech Piórko

Sales Director AC Power, Racks & Solutions,

Poland & Baltics, Emerson Network Power

W najbliższych latach kierunki rozwoju systemów zasilania

dla IT nie zmienią się. Będą nimi maksymalizacja wydajności, uzyskiwanie

kolejnych poziomów skalowalności oraz nacisk na niezawodność. Szczególnie ważna

będzie skalowalność, ponieważ poszukiwane będą systemy zasilania pracujące

optymalnie w każdych warunkach, rozwijające się wraz ze wzrostem

zapotrzebowania oraz korzystające z zalet modułowości także na poziomie

pojedynczego elementu składowego (np. łatwo serwisowalne moduły funkcjonalne w

obrębie jednej szafy).

Natomiast w obszarze klimatyzacji precyzyjnej w tym roku

nasilał się będzie trend modyfikacji i budowy w nowych centrach danych systemów

typu Air to Air, wykorzystujących technologię odparowania wody w celu znacznego

zwiększenia efektywności energetycznej. Drugim trendem wzrostowym będą źródła

chłodu w tradycyjnych instalacjach wody lodowej wykorzystujące efekt

adiabatycznego ochłodzenia powietrza, co również poprawia efektywność energetyczną

instalacji klimatyzacyjnych oraz bezpieczeństwo pracy systemu w krytycznych

warunkach.

Maciej Polak

Product Business Development Manager, Fujitsu

Technology Solutions

W 2015 r. możemy oczekiwać ciekawych zmian w trzech

obszarach związanych z nowoczesnym centrum danych. Coraz śmielej stosowaną w

rozwiązaniach nie tylko klasy enterprise będą pamięci typu flash – coraz tańsze

i łatwiej dostępne. Dla rynku ważne jest też pojawienie się urządzeń zupełnie

nowej gamy rozwiązań klasy Software Defined Storage i związana z tym trendem

konsolidacja rozwiązań pamięci masowych pod kątem potrzeb aplikacji. Trzeci z

obszarów to zarządzanie złożonymi rozwiązaniami dostarczanymi przez wielu

dostawców, konsolidacja, skalowanie i łatwe zarządzanie heterogenicznymi środowiskami.

Artur Pająk

Senior IT Solution Architect, Huawei Enterprise

W 2015 roku z pewnością zwiększy się zainteresowanie

rozwiązaniami analitycznymi typu database in memory, takimi jest SAP HANA.

Klienci coraz wyraźniej dostrzegają zalety błyskawicznego analizowania zachowań

rynku i dostosowywania do zmieniających się warunków. W tej dziedzinie

popularnością będą cieszyć sie rozwiązania serwerowe z czteroma i więcej procesorami.

Macierze dyskowe będą zmierzać w kierunku głębokiej

integracji pomiędzy funkcjami zapewnianymi przez sprzęt (kopie migawkowe,

replikacja), systemami operacyjnymi, wirtualizatorami systemów operacyjnych jak

i systemami kopii zapasowych. Macierze NAS będą stosowane zarówno jako archiwum

do przechowywania dużych ilości danych (rzędu petabajtów) jak i dostarczania

mechanizmów efektywnego wyszukiwania/przetwarzania danych z archiwum, np.

poprzez zastosowanie technologii MapReduce.

Paweł Bondar

Resiliency Services Sales Leader, IBM

W 2014 r. tradycyjnie aktywne biznesowo były firmy z

sektora finansowego i publicznego, ale wyróżniało się też parę firm z sektora

handlu detalicznego. Przez najbliższe lata będziemy świadkami szczególnego

zainteresowania wszelkiego typu rozwiązaniami z obszaru analityki biznesowej i

przetwarzania w chmurze.

Będą rosły także możliwości rozwiązań takich jak IBM

Watson Analytics, które będą ułatwiać proces wyciągania wniosków z informacji

poprzez zadanie pytania w języku naturalnym, a dostęp do wyników analizy

przeprowadzonych przez superkomputer można uzyskać za pomocą komputera,

smartfona czy innego urządzenia.

Maciej Sobianek

Microsoft Azure Product Manager, Microsoft

Dla wielu firm udogodnienia w modelu infrastruktury jako

usługi to wciąż za mało. Oczekują one pełnej automatyzacji i maksymalnego

uproszczenia w zarządzaniu aplikacjami, które wykorzystują same lub oferują

swoim klientom – poszukują rozwiązań i narzędzi w modelu PaaS oraz SaaS.

W roku 2015 dynamika zmian przyspieszy w porównaniu z

rokiem poprzednim. Już na początku stycznia wprowadziliśmy nowości zarówno w

obszarze usług IaaS (maszyny z serii G: 32 rdzenie i 448 GB RAM), jak również

usług PaaS (integracja platformy Azure z technologią Docker pozwalającą na

szybsze implementowanie usług i aplikacji). W 2015 r. z pewnością zachowany

zostanie również trend zgodnie z którym to partnerzy firmy Microsoft

wykorzystują rozwiązania PaaS do budowania własnych aplikacji (Partnerzy ISV)

oraz świadczenia usług utrzymania aplikacji i systemów klientów (Partnerzy SI).

Dariusz Koseski

wiceprezes

Schneider Electric

Rynek zasilania gwarantowanego będzie rozwijał się

stabilnie, nie spodziewamy się znaczących zmian, a zdecydowanie bardziej ustabilizowanego

wzrostu sprzedaży w segmencie urządzeń jednofazowych 5-20 kVA oraz trójfazowych

40–100 kVA. Większego znaczenia nabiorą również urządzenia o małej mocy z

krótkim czasem podtrzymania, które znajdują coraz większe zastosowanie w

gospodarstwach domowych. W przypadku klimatyzacji precyzyjnej będziemy mieli do

czynienia z rozwojem, a raczej unowocześnianiem pojedynczych rozwiązań dla

konkretnych typów data center.

Krzysztof Waszkiewicz

Business Solutions, Architect, VMware

Model Infrastructure as a Service w czasach, kiedy chmura

obliczeniowa stała się już niemal wszechobecna, jest swego rodzaju fundamentem

budowania nowoczesnego IT. Naturalnym więc jest dalszy rozwój tego modelu, a

zatem i kolejne inwestycje, wdrożenia i rozwój idący w tym kierunku. Można też

spodziewać się, że dalszy rozwój poszczególnych komponentów programowo

definiowanego centrum danych (Software Defined Data Center), szczególnie w

zakresie pamięci masowych i sieci, pozwoli na jeszcze bardziej elastyczne

dostosowywanie oferty infrastruktury do potrzeb działów biznesowych.

Wiele organizacji dość szybko radzi sobie z wdrożeniami

systemu automatycznie kreowanych i serwowanych maszyn wirtualnych, natomiast

pełny model IaaS wymaga znacznie większej heterogeniczności i szerszego

podejścia. Dlatego coraz częściej pracujemy nad projektami uwzględniającymi

różne wirtualne platformy, także pamięci masowe i sieci.

Podobne artykuły

Proget Software: dojrzałe rozwiązanie EMM

Polscy programiści z Proget Software opracowali nowoczesny system klasy EMM do zarządzania urządzeniami mobilnymi w przedsiębiorstwach i ochrony zgromadzonych na nich danych, zgodnie z przyjętymi regułami polityki bezpieczeństwa.

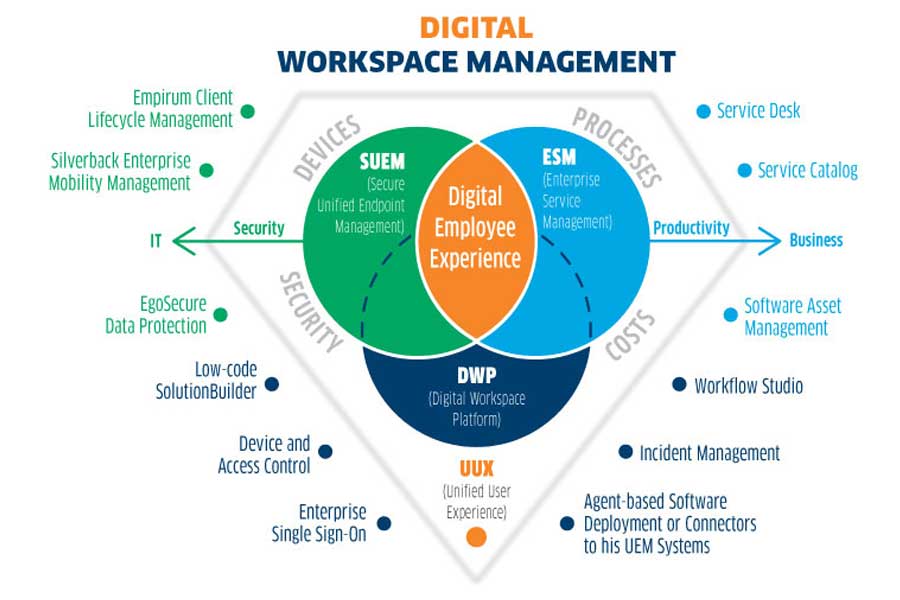

Pełna ochrona z Matrix42

Nigdy wcześniej stwierdzenie, że rzeczywistość biznesowa postawiła przed administratorami IT ogromne wyzwania, nie było tak prawdziwe i tak istotne, jak obecnie. Są one związane z bezpieczeństwem infrastruktury sieciowej, ale też urządzeń końcowych – stacjonarnych i mobilnych.

UEM, czyli najwyższy czas na unifikację

Dostawcy rozwiązań teleinformatycznych bardzo często dążą do integracji systemów. Z taką sytuacją mamy do czynienia w segmencie produktów do zarządzania urządzeniami końcowymi.