Nowa generacja zagrożeń wpływa na rozwój zabezpieczeń

W branży IT coraz częściej mówi się o ochronie nowej generacji (Next Generation Security). Pod tym hasłem producenci oferują kolejne produkty i rozwiązania; takie miano często noszą też branżowe konferencje. Czy rzeczywiście doszło do jakiegoś przełomu w zabezpieczaniu systemów informatycznych, czy to tylko nowy chwyt marketingowy?

Rynek systemów do zabezpieczania infrastruktury IT chyba nigdy nie był tak dynamiczny i zmienny jak obecnie. Stoi wobec poważnych wyzwań – z jednej strony powszechnej mobilności i konsumeryzacji IT, z drugiej coraz lepiej zorganizowanej przestępczości komputerowej i swoistej automatyzacji ataków.

Pojawienie się pojęcia „nowa generacja” zbiega się z nasilaniem przekonania, że pewne, od lat znane elementy ochrony, takie jak tradycyjne firewalle czy antywirusy, po prostu się przeżyły. Jeśli tak rzeczywiście jest, to co je dziś zastępuje?

Przełom czy ewolucja?

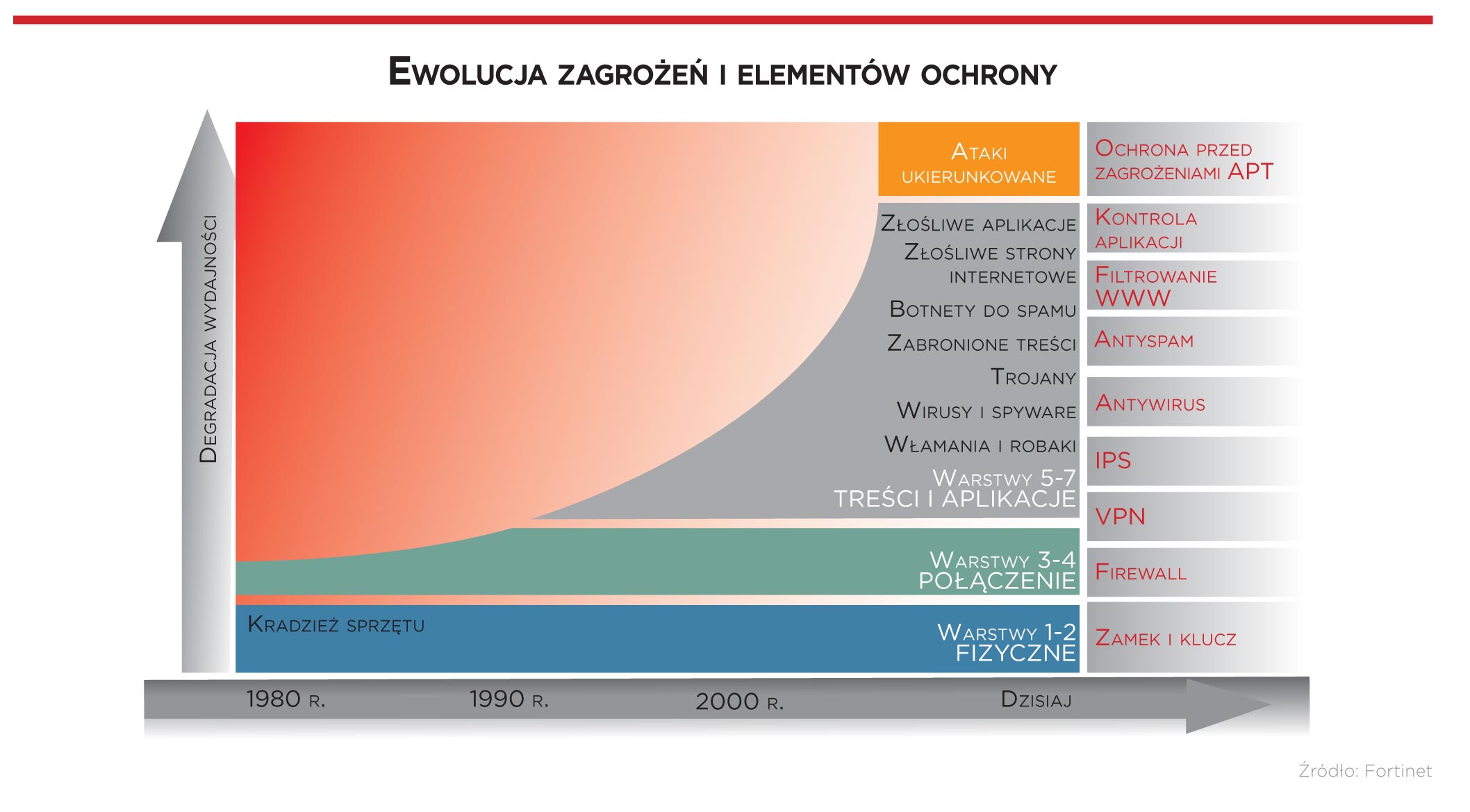

Zdaniem Mariusza Stawowskiego, dyrektora Działu Usług Profesjonalnych Clico, nowe rozwiązania ochronne nie są przełomem, tylko naturalnym rozwojem technologii zabezpieczeń, nadążającej za rozwojem zagrożeń.

– Przestępcy zaczęli atakować popularne usługi takie, jak WWW i portale społecznościowe, więc efektywne zabezpieczenia muszą kontrolować także te obszary – twierdzi.

W przypadku tradycyjnych firewalli pytanie o sens ich stosowania z czasem było coraz bardziej zasadne, ponieważ ich podstawowa funkcja – blokowanie ruchu (w tym ataków) za pomocą określonych portów sieciowych – stawała się bezużyteczna. Ataki nie mogą już być w ten sposób zablokowane, gdyż przygniatająca większość z nich odbywa się poprzez porty które muszą być zawsze otwarte (głównie HTTP i HTTPS). Dlatego w interesie firm jest zastąpienie tradycyjnych firewalli, kontrolujących numery portów, rozwiązaniami nowej generacji. Użytkownicy coraz częściej mają tego świadomość.

Czym zatem są zapory nowej generacji? Wykorzystywany marketingowo przez wielu producentów rozwiązań bezpieczeństwa termin Next-Generation FireWalls (NGFW) Gartner definiuje jako „zintegrowaną platformę bezpieczeństwa, która z prędkością łącza przeprowadza głęboką inspekcję ruchu i blokuje ataki”. Firma analityczna wymienia szereg funkcji, jakimi powinien cechować się NGFW: kontrolę aplikacji bez względu na numery portów, tunelowanie i szyfrowanie, ochronę przed intruzami (IPS) oraz możliwość uwierzytelniania użytkowników zintegrowanego z Active Directory czy innym centralnym systemem weryfikacji uprawnień. Rozpoznawanie i kontrola wykorzystywanych aplikacji, bez względu na użyty port, protokół, szyfrowanie czy techniki ukrywania, pozwala w NGFW stosować skuteczną politykę bezpieczeństwa i to najczęściej – niezależnie od miejsca – taką samą zarówno dla pracowników stacjonarnych, jak i mobilnych (poza siedzibą firmy), co gwarantuje jej spójność.

NGFW czy UTM?

Kilka lat przed zaporami NGFW zaczął funkcjonować termin Unified Threat Management (UTM), określający zintegrowane rozwiązanie realizujące (poza firewallem stanowym) również ochronę antywirusową i przed włamaniami (IPS), kontrolę aplikacji, funkcje antyspamowe, filtrowanie treści WWW i inne. Obecnie technologie wykorzystywane w NGFW i UTM są praktycznie te same, a produkty obu rodzajów mają podobną funkcjonalność. Bywa, że urządzeniami UTM są określane te produkty, które mają mniejszą przepustowość (oferowane mniejszym firmom), ale nie jest to reguła i wszystko sprowadza się najczęściej do marketingu. Przy niezbyt ostrym podziale między wymienionymi rozwiązaniami ochronnymi to od producenta zależy, jakim określeniem promuje swoje wyroby. Tego typu zintegrowane produkty ochrony, określane mianem urządzeń nowej generacji, oferują m.in.: Check Point Software Technologies, Cisco Systems, Fortinet, Juniper Networks, McAfee, Palo Alto Networks, SonicWALL, Sophos i WatchGuard.

Nową generacją zabezpieczeń jest też nazywane rozwiązanie firmy FireEye, która uważa swój produkt za przełom w dziedzinie ochrony systemów IT przed najnowszymi zagrożeniami.

– Technologia FireEye uzupełnia klasyczne systemy ochrony, czyli zapory sieciowe, IPS-y, antywirusy i bramki oparte na sygnaturach, reputacji i heurystyce – mówi Mirosław Szymczak, Channel Manager Eastern Europe w FireEye. – W swoich produktach wykorzystujemy opracowaną przez nas platformę Multivendor Execution Engine, wewnątrz której podejrzany kod lub plik jest uruchamiany w celu sprawdzenia, czy wywołuje takie działania jak modyfikowanie rejestru systemowego, operacje zapisu i odczytu w plikach systemowych, tworzenie nowych plików, otwarcie portów sieciowych, zdalne pobieranie plików, przerywanie działania innych aplikacji i inne podobne, charakterystyczne dla złośliwych programów. Na tej podstawie dokonuje się oceny, czy badany kod stanowi zagrożenie. Wszystko dzieje się w wydzielonym wirtualnym środowisku, działającym w urządzeniu o bardzo dużej mocy obliczeniowej, zainstalowanym w sieci klienta.

Metoda uruchamiania podejrzanego kodu w wirtualnej maszynie nosi nazwę sandboxingu. Rozwiązania FireEye, Trend Micro Deep Discovery, a także Netwitness (RSA), Imperva SecureSphere, Check Point Threat Emulation i inne pojawiły się jako odpowiedź na zagrożenia typu zero day i ukierunkowane ataki (APT), z którymi nie radzą sobie klasyczne, oparte na sygnaturach antywirusy. Zadaniem takich narzędzi jest monitorowanie sieci i odkrywanie niebezpiecznych zachowań przez uruchamianie podejrzanego kodu w miejscach odseparowanych od systemu produkcyjnego.

O tym, że klasyczne programy antywirusowe przestają być skuteczne, mówi coraz więcej raportów. To jedna z najważniejszych konkluzji tegorocznego opracowania „Modern Malware Review” firmy Palo Alto Networks. Przyczyną tego zjawiska jest skuteczne unikanie wykrycia przez różne rodzaje złośliwego oprogramowania, które jest obecnie bardzo dobrze przystosowane do ukrywania swojej obecności w zaatakowanych systemach. Zdaniem autorów raportu aż 95 proc. oprogramowania zagrażającego bezpieczeństwu, które dostało się do sieci przez protokół FTP, pozostawało niewykryte przez ponad 30 dni.

Mariusz Rzepka

Territory Manager na Polskę, Ukrainę i Białoruś, Fortinet

Budowanie systemu bezpieczeństwa teleinformatycznego z wykorzystaniem rozwiązań realizujących pojedyncze funkcje, chociaż kiedyś skuteczne, obecnie zdecydowanie odchodzi w przeszłość. Mnoży to bowiem kolejne problemy: skomplikowaną architekturę, utrudnione zarządzanie (każdy z tych systemów może pochodzić od innego producenta), konieczność szkolenia kadry informatycznej w zakresie osobnych rozwiązań, brak jednolitego wsparcia technicznego oraz utrudnioną analizę ruchu w sieci i incydentów naruszania bezpieczeństwa.

Z pomocą przychodzą rozwiązania Unified Threat Management, które umożliwiają jednoczesne uproszczenie infrastruktury sieciowej, zmniejszenie kosztów i ułatwienie administrowania siecią, a przy tym radykalnie podnoszą poziom bezpieczeństwa chronionej firmy. Dzieje się tak m.in. dzięki temu, że systemy UTM wykrywają ataki we wszystkich warstwach modelu OSI/ISO, również na poziomie aplikacyjnym, i wymuszają politykę bezpieczeństwa dostosowaną do poszczególnych użytkowników, jednocześnie zapewniając wysoką przepustowość transmisji danych.

Na model ochrony firmowej sieci wpływa dziś przede wszystkim wymóg permanentnej mobilności pracowników. Dlatego urządzenia instalowane na brzegu sieci powinny być wyposażone w zestaw mechanizmów umożliwiających zdalny dostęp, zarówno przez oprogramowanie klienckie, jak również przez przeglądarkę internetową. Niezbędnymi elementami ochrony infrastruktury informatycznej przedsiębiorstwa stają się więc wspomniane zapory nowej generacji, sondy wykrywające włamania (IPS), bezpieczne web proxy i systemy ochrony poczty. Ochrona WWW i poczty elektronicznej może się odbywać również w chmurze, co tworzy bardzo rozwojowy obszar w kontekście sprzedaży zabezpieczeń w modelu subskrypcyjnym.

Co z zagrożeniami?

Nagłośnione ostatnio w prasie cyberataki i kradzieże danych pokazują, że mimo wykorzystywania przez firmy całego arsenału ochrony, przestępcy potrafią znaleźć sposób na przełamanie zabezpieczeń i wtargnąć do systemów zawierających wrażliwe informacje. Zazwyczaj potwierdzają jednak prostą prawdę: najczęściej dochodzi do nich z powodu najzwyklejszych zaniedbań, gdy atakujący mają ułatwioną drogę do firmowej sieci i danych. Niejednokrotnie atak rozpoczyna się od phisingu – odpowiednio spreparowany e-mail zawiera złośliwy kod wykorzystujący luki w systemie użytkownika bądź link do wrogiej strony internetowej.

Coraz częściej można też obserwować ataki, przeprowadzane po to, by wymusić okup na firmie czy osobie fizycznej. Atakujący żąda opłaty za usunięcie złośliwego oprogramowania (ma ono już swoją nazwę – ransomware), które – bez wiedzy użytkowników – zainstalowało się na komputerach.

Wiele zuchwałych ataków przeprowadzonych w ostatnim czasie, takich jak przejęcie przez chińskich hakerów kontroli nad komputerami redakcji „New York Timesa”, dowodzi, że łatwo stworzyć wirusa, który pozostanie niewykryty przez klasyczne pakiety zabezpieczeń. Często do przygotowania takich plików nie trzeba zaawansowanej wiedzy, można wykorzystać dostępne w Internecie kody publikowane przez specjalistów ds. bezpieczeństwa.

Jednak nawet ci, którym nie chce się skorzystać z gotowych szablonów, wciąż mają wiele okazji do cyberprzestępstw. Od jakiegoś czasu w tym procederze jest oferowana kompleksowa pomoc – w najróżniejszym zakresie i w modelu usługowym. Crimeware-as-a-Service opracowują programiści tworzący i sprzedający exploity, malware, spyware, boty, narzędzia do wysyłania spamu i służące do ukrywania złośliwej natury kodu. Sprzedawany jest także sprzęt do przełamywania zabezpieczeń i kradzieży (np. do skanowania kart płatniczych) i usługi testowania złośliwego kodu pod kątem odporności na oprogramowanie zabezpieczające.

Przeprowadzenie ataków na skalę masową to dziś nieskomplikowana sprawa, bo cyberprzestępcy świadczą opartą na botnetach usługę w modelu Infrastructure as a Service. Ta łatwo dostępna na zasadach komercyjnych przestępcza infrastruktura sprawiła, że lawinowo rośnie liczba ataków DDoS. Każdy, kto zapłaci odpowiednią kwotę, może przeprowadzić zmasowany atak, który może unieruchomić nawet największy serwis internetowy (czego w tym roku doświadczyły m.in. polskie banki oraz serwis aukcyjny Allegro). Może też wysyłać masowo spam i szkodliwy kod.

Obecnie ataki często bywają wielowektorowe, co oznacza konieczność jednoczesnego stosowania systemów chroniących przed różnymi rodzajami zagrożeń. Pojawiła się też nowa kategoria ataków – szytych na miarę i wycelowanych z chirurgiczną precyzją w architekturę teleinformatyczną

danej firmy. Przed takimi działaniami, określanymi mianem Advanced Persistent Threats, najtrudniej się bronić.

Jednak nawet najbardziej wyrafinowana technika zewnętrznego ataku nie jest tak skuteczna, jak wykorzystanie socjotechniki do przemycenia wrogiego kodu, a następnie zaatakowania systemu informatycznego od wewnątrz. O tym nie można zapomnieć.

Wzbudzić strach i po sprawie

Jeśli pomyśli się o wszystkich zagrożeniach, to sprzedawanie zabezpieczeń wydaje się być prostą sprawą. Za oceanem już dawno wpadli na pomysł, że wystarczy serwowany produkt obficie podlać sosem o nazwie FUD (Fear + Uncertainty + Doubt), którego składniki to strach, niepewność i wątpliwości, by przerażony klient wszystko kupił. Warto w tym celu pokazać np. kilka „wstrząsających” raportów na temat włamań do sieci i kradzieży wrażliwych danych. Nic trudnego, tylko czy to naprawdę działa?

Ta metoda w rzeczywistości wydaje się przynosić skutek odwrotny do zamierzonego. Bombardowani przez lata „przerażającymi” danymi z raportów klienci uodpornili się na nie. Przeciętna firma z sektora MSP na co dzień ma do czynienia ze złośliwym oprogramowaniem i spamem, ale tylko niewielki procent przedsiębiorców notuje prowadzącą do znacznych strat kradzież tożsamości. Przedstawiane przez handlowców najczarniejsze scenariusze zdarzają się stosunkowo rzadko, więc dyrektorzy IT w firmach przyzwyczajają się do myślenia, które można streścić następująco: „nic szczególnie złego nie zdarzyło nam się w zeszłym roku, więc w tym nie będzie inaczej”.

W dodatku badania wskazują, iż połowa szefów małych firm jest zdania, że ich systemy informatyczne nie zawierają żadnych cennych danych, które mogłyby zainteresować napastników. Pozostali są najczęściej przekonani o wysokim poziomie zabezpieczeń posiadanych rozwiązań IT. Jest pewne, że ani jedni, ani drudzy nie mają racji. Jak ich o tym przekonać, skoro straszenie przestaje działać?

Patrzeć oczami klienta

Zamiast próbować przestraszyć zagrożeniami, dostawcy rozwiązań IT powinni skupić się na realnej ocenie sytuacji i rzeczywistych uwarunkowaniach, w jakich funkcjonuje klient. Doskonałym argumentem będą regulacje prawne, głównie dotyczące ochrony danych osobowych. Są one obiektywnym czynnikiem, nie można ich ominąć, a nieprzestrzeganie ich grozi dotkliwymi konsekwencjami. Jeśli przedstawiamy zagrożenia, ważne by „czarne scenariusze” dostosować do specyfiki obsługiwanej firmy i jej wielkości, np. pokazać, że aspekt wycieku danych finansowych nie będzie tak dotkliwy dla spółki niepublicznej, jak wyciek bazy danych klientów do lokalnej konkurencji.

Istotnym elementem jest doradztwo biznesowe ukazujące potencjalnemu klientowi wymierne korzyści z inwestowania w system bezpieczeństwa. Właściciele przedsiębiorstw i członkowie zarządów są bowiem zainteresowani tylko tymi rozwiązaniami, które zwiększają produktywność pracowników lub minimalizują ryzyko strat finansowych.

Przemysław Kucharzewski

dyrektor działu Enterprise Business Group w AB

Zachęcamy partnerów do aktywnego angażowania się w poznanie modelu biznesowego klientów i stylu ich pracy. Taka integracja zdecydowanie ułatwi wykrycie potencjału sprzedażowego. Firmy mogą chcieć inwestować w nowe systemy związane z bezpieczeństwem z wielu przyczyn, np. ze względu na świadomość zagrożeń, konieczność zapewnienia zgodności z obowiązującymi przepisami i wymogami kooperantów, otwarcie nowych oddziałów, rozszerzenie oferty lub zakresu usług, zatrudnianie nowych pracowników, czy próbę zmiany wizerunku.

Gdy mowa o kosztach, to integrator powinien pomóc klientowi zrozumieć, o co chodzi w zarządzaniu ryzykiem. Gdy klient ma niewystarczającą wiedzę, to ryzyko może wydać się albo bardzo duże (i wkroczy do akcji wspomniany FUD, który nie działa), albo bardzo małe (tym bardziej trudno coś sprzedać). Jeśli pomożemy klientowi racjonalnie przeanalizować ryzyko, to argumenty za kupnem same się znajdą, dlatego powinniśmy się posługiwać autentycznymi danymi klienta. W ten sposób uświadomimy mu rzeczywiste konsekwencje braku polityki bezpieczeństwa IT. Pokażemy skutki przestoju firmy spowodowanego atakiem, w tym spadek zaufania do firmy i wymierne straty finansowe, które może przynieść.

Informowanie klienta o zagrożeniach nie musi skończyć się z wdrożeniem projektu. Dobrym sposobem na kontynuowanie współpracy są stałe szkolenia pracowników, bo to w głównej mierze od nich zależy, jak skuteczny będzie wdrożony system bezpieczeństwa.

Jak natomiast powinien funkcjonować VAR czy integrator w relacji z dostawcami rozwiązań, by osiągnąć sukces na rynku? Zdaniem Krzysztofa Wójtowicza, dyrektora zarządzającego polskim oddziałem Check Point Software Technologies, między tymi podmiotami musi istnieć bardzo ścisła współpraca. Zaangażowanie dostawcy jest obecnie niezbędnym elementem zapewnienia klientowi pełnej ochrony, biorąc pod uwagę takie aspekty jak zwrot z inwestycji, dostępność konsultantów oraz wskazówki pomagające w implementacji. W wielu przypadkach niezbędne są również profesjonalne usługi dostawcy: – Rola partnerów VAR jest coraz większa, gdyż muszą zapewnić połączenie i współdziałanie technologii od różnych producentów. Muszą zatem coraz ściślej współpracować z dostawcami, aby brać udział we wdrażaniu systemów zabezpieczających.

Jak chmura wpływa na rynek bezpieczeństwa?

Cisco przewiduje, że w ciągu najbliższych 5 lat ilość informacji przechowywanych i przetwarzanych w światowych centrach danych zwiększy się czterokrotnie („Cisco Annual Security Report 2013”). Najszybciej ma rosnąć ilość danych przetwarzanych i udostępnianych w modelu chmury. W 2016 r. ruch sieciowy, generowany przez dostęp do danych w modelu cloud computing, stanowić będzie dwie trzecie całego ruchu sieciowego z centrów przetwarzania danych i do nich. Jak to ma się jednak do zgłaszanych od dłuższego czasu obaw użytkowników o poufność danych, ich dostępność i utrzymanie w zgodności z przepisami o przechowywaniu poufnych zasobów w chmurze?

W tym kontekście bardzo ciekawie wypadają rezultaty ankiety SMB Cloud Survey 2013, przeprowadzone przez Ipsos MORI na zlecenie Microsoftu. Wynika z nich, że 73 proc. ankietowanych przedstawicieli małych i średnich firm w Polsce skłania się ku chmurze właśnie ze względu na poczucie bezpieczeństwa, a 70 proc. jest wręcz przekonanych, że usługi w chmurze podnoszą bezpieczeństwo danych. Jeszcze większe zaufanie do cloud computingu mają przedsiębiorstwa z regionu Europy Środkowo-Wschodniej – średnio 80 proc. przedstawicieli małych i średnich firm wskazuje bezpieczeństwo danych jako jedną z kluczowych zalet modelu usługowego.

Ten raport wcale nie jest pierwszym, który progozuje sukces usług ochrony danych w modelu usługowym. Lokalny dostawca może wraz z dostępem szerokopasmowym sprzedawać rozwiązania zabezpieczające, zarządzane przez niego właśnie w chmurze. I rzeczywiście, widać rosnące zainteresowanie operatorów telekomunikacyjnych i dostawców Internetu modelem Managed Security Service Provider, w którym ochrona sprzedawana jest jako usługa. To jeden z przykładów, jak dostawcy usług w prosty sposób mogą tworzyć wartość dodaną. Coraz więcej z nich rozważa sprzedaż usług na żądanie, w rozliczeniu godzinowym, dziennym lub tygodniowym, z możliwością samodzielnego ich włączania i wyłączania.

Dostawcy usług w chmurze zwracają uwagę, że są one metodą na obniżenie TCO przy zachowaniu wysokiej funkcjonalności. Zmniejszenie kosztów jest związane przede wszystkim ze standaryzacją systemu zarządzania infrastrukturą sieciową i wyeliminowaniem procesu dystrybucji niezbędnego oprogramowania.

Czy rzeczywiście małe i średnie firmy będą masowo korzystać z modelu usługowego, bo umożliwia zastosowanie rozwiązań, które dotychczas nie były dla nich dostępne lokalnie z powodu złożoności wdrożenia i ceny? Czy duże przedsiębiorstwa będą widziały w chmurze szansę na redukcję kosztów wdrożenia i optymalizację wydatków na utrzymanie usług? Wyniki badań nastawienia klientów do chmury wskazują, że jesteśmy coraz bliżej przełomu (na początku zdecydowanie przeważały obawy). Na pewno o sukcesie bezpieczeństwa „as a service” (a w zasadzie wszystkich usług świadczonych w modelu chmury) zdecydują dwa podstawowe czynniki: przystępność cenowa usługi oraz łatwość jej używania.

Wybrani producenci systemów ochrony sieci oraz ich dystrybutorzy na polskim rynku

Barracuda Networks: Dagma

Blue Coat: Computerlinks, Veracomp

Celestix Networks: Bakotech

Check Point: Clico, RRC

Cisco: ABC Data, Konsorcjum FEN, RRC, Tech Data

Clearswift: Veracomp

Core Security: Passus

Corero: Veracomp

Cyberoam: Konsorcjum FEN

Dell SonicWALL: RRC

Endian: Computerlinks

FireEye: World IT Systems

Fortinet: Veracomp

HID Global: Clico

IBM: Avnet, RRC, Veracomp

Imperva: Clico

Juniper Networks: Avnet, Clico

NCP: Clico

NETASQ: Dagma

Palo Alto Networks: Clico

Radware: Clico, Veracomp

RSA: Arrow ECS, RRC

Sourcefire: Veracomp

StoneSoft: Clico

Trend Micro: ABC Data, Clico

Trustwave: Computerlinks, Veracomp

Tufin: Clico

Ucopia Communications: Clico

WatchGuard: Connect Distribution

Xceedium: World IT Systems

ZyXEL: AB, Action, eD’ System, RRC, Veracomp

Podobne artykuły

Commvault Data Platform: uniwersalność, otwartość, niezależność

Najnowsza wersja oprogramowania do ochrony danych to platforma nowej generacji. Dlatego Commvault Simpana zmienia nazwę na Commvault Data Platform.